ホームページにアクセスしてほしくないbotの制御を行うことができます。robots.txtに記述をしてアクセス制御を行います。今回は、robots.txtを使用してbotのアクセス制御をする方法について紹介いたします。

robots.txtについて

robots.txtを使用してbotのアクセスを簡単に制御することができます。

robots.txtでのアクセス制御は次のようになります。

- robots.txtを作成する

-

アクセス制御するbotを記述する

robots.txtを使用してアクセス制御を行う場合、最初にこのファイルにアクセスしてくるbotに対して有効になります。

robots.txtにアクセスしてこないbotはアクセス制御することができません。その場合は、他の方法で対応する必要があります。

※説明は、ConoHa Wingを使用して行っています。

robots.txtの作成

サーバー上のサイトのルートディレクトリに、robots.txtを作成します。

使用してサーバーの機能を使用すると簡単に作成することができます。

サーバーにConoHa Wingを使用している場合は、ファイルマネージャーを使用すると簡単に作成できます。

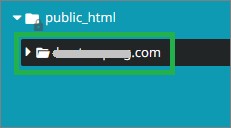

ファイルマネージャーを表示して、左側の一覧から「public_html」の下にあるサイトをクリックします。

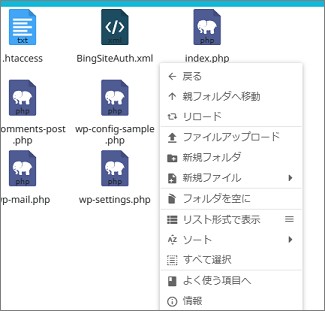

右側のファイルが表示されている場所で、右クリックをしてメニューを表示します。

表示されたメニューで「新規ファイル」にカーソル移動すると、作成するファイルの一覧が表示されます。次に、表示された一覧の「TXT: プレインテキスト」をクリックします。

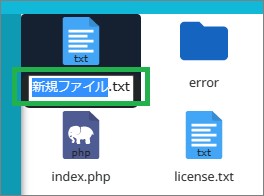

「新規ファイル.txt」が作成されるので、ファイル名を「robots.txt」に変更します。

これで「robots.txt」の作成ができます。

botの記述

robots.txtに次の記述を追加しします。

robots.txtを右クリックして、表示されたメニューで「編集」クリックします。

表示された一覧から、使用するエディターを選択して記述します。

Disallow: /

User-agent: にアクセス制御するbot名を記述します。

Disallow: にアクセス制限する場所を記述します。

「/」を記述するとサイト全体のアクセスを制限することができます。

その他について

robots.txtでアクセス制御が有効になるbotは、最初にrobots.txtにアクセスしてくるbotになります。robots.txtに記述されている内容を確認して、アクセスしないようしてくれます。

botがrobots.txtにアクセスしているかは、アクセスログを確認すると判断することができます。

robots.txtに設定したあとは、アクセスログで確認をすると良いです。しばらく経過して、アクセスログを確認してみると、効果が確認できると思います。

ConoHa Wingのアクセスログを確認する方法はこちらで説明しています。

まとめ

今回は、robots.txtを使用してbotのアクセス制御をする方法について紹介しました。ホームページにアクセスしてほしくないbotを簡単に制御することができるので良いと思います。robots.txtで制御できないbotもありますが、記述が簡単で便利です。

読んでいただき、ありがとうございます。

参考になりましたら、幸いです。